LLaMA Efficient Tuning的简介

2023年6月发布的LLaMA Efficient Tuning,它是一款可高效微调【全参数/LoRA/QLoRA】主流大模型【ChatGLM2/LLaMA2/Baichuan等】的高效工具,包括预训练、指令监督微调、奖励模型训练、PPO 训练、DPO 训练等功能。目前该项目仍在持续更新。

官方地址:

GitHub - hiyouga/LLaMA-Efficient-Tuning: Easy-to-use LLM fine-tuning framework (LLaMA-2, BLOOM, Falcon, Baichuan, Qwen, ChatGLM2)

文章来源地址https://uudwc.com/A/k93DY文章来源:https://uudwc.com/A/k93DY

1、支持的模型

| 模型名 | 模型大小 | 默认模块 | Template |

|---|---|---|---|

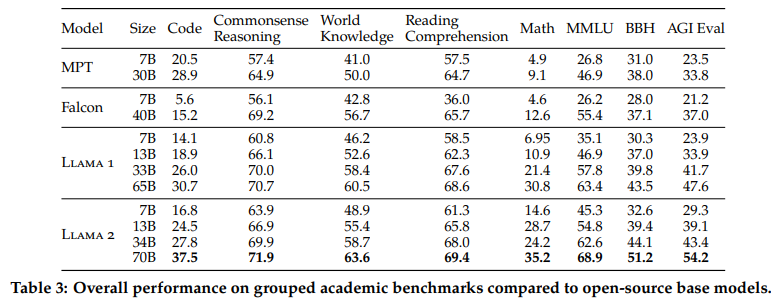

| LLaMA | 7B/13B/33B/65B | q_p |