- 决策树

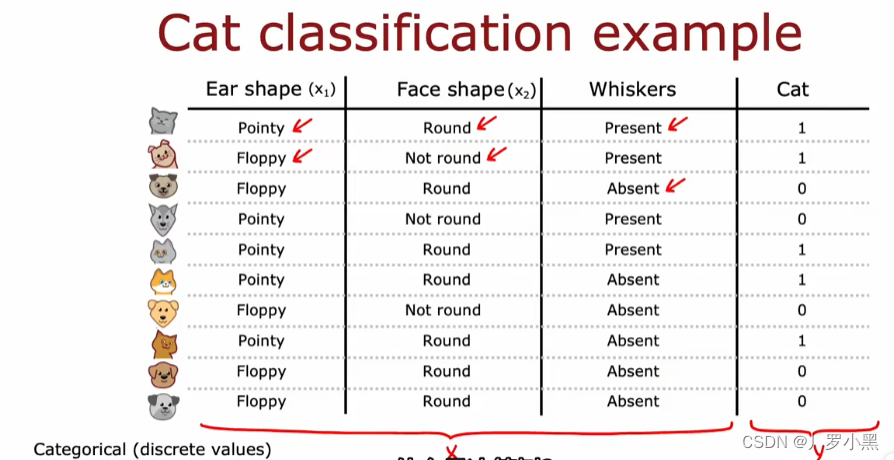

- 上图的数据集是一个特征值X采用分类值,即只取几个离散值,同时也是一个二元分类任务,即标签Y只有两个值

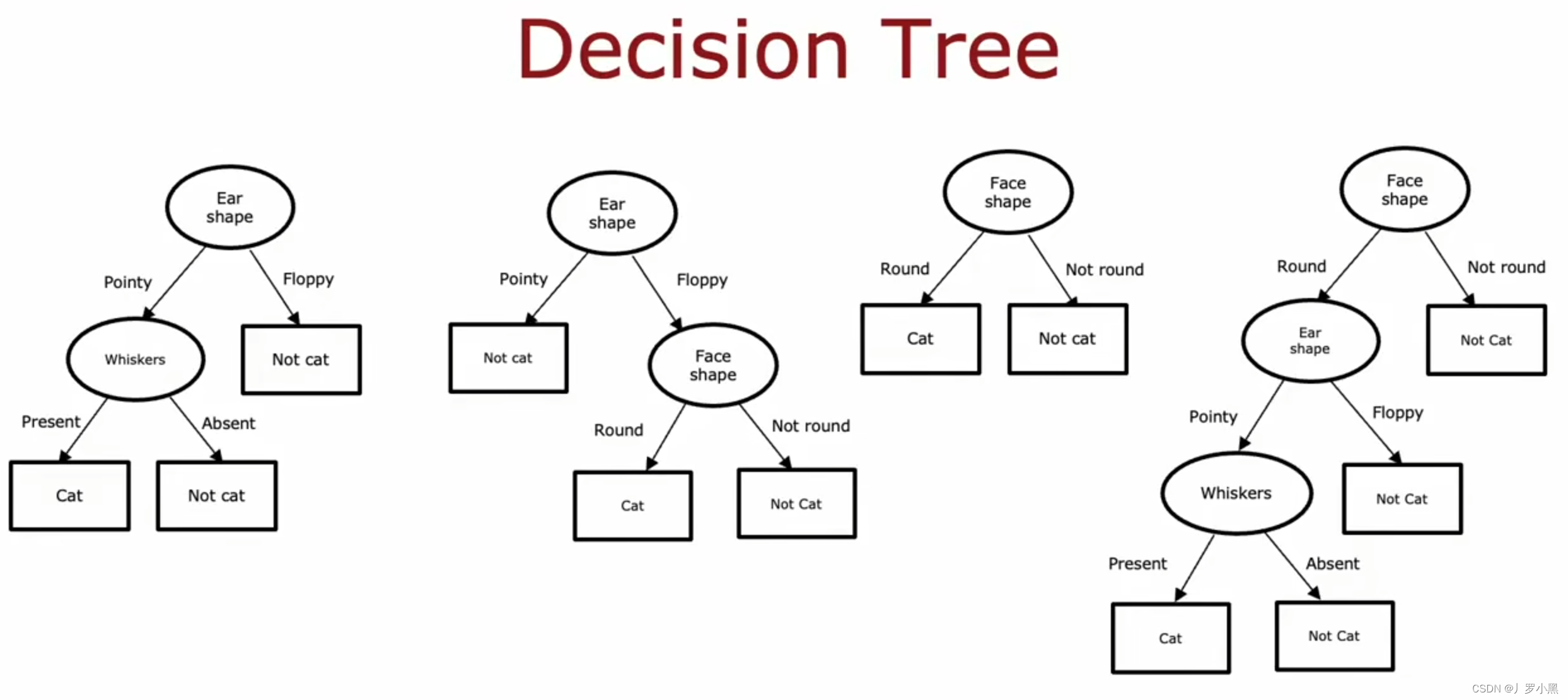

- 上图为之前数据集对应的决策树,最顶层的节点称为根节点,椭圆形节点称为决策节点,矩形节点称为叶子节点

- 决策树学习算法的工作是,在所有可能的决策树中,选择一个在训练集上能表现良好,并能很好的推广到新数据(即交叉验证集和测试集)的决策树

- 决策树的学习过程

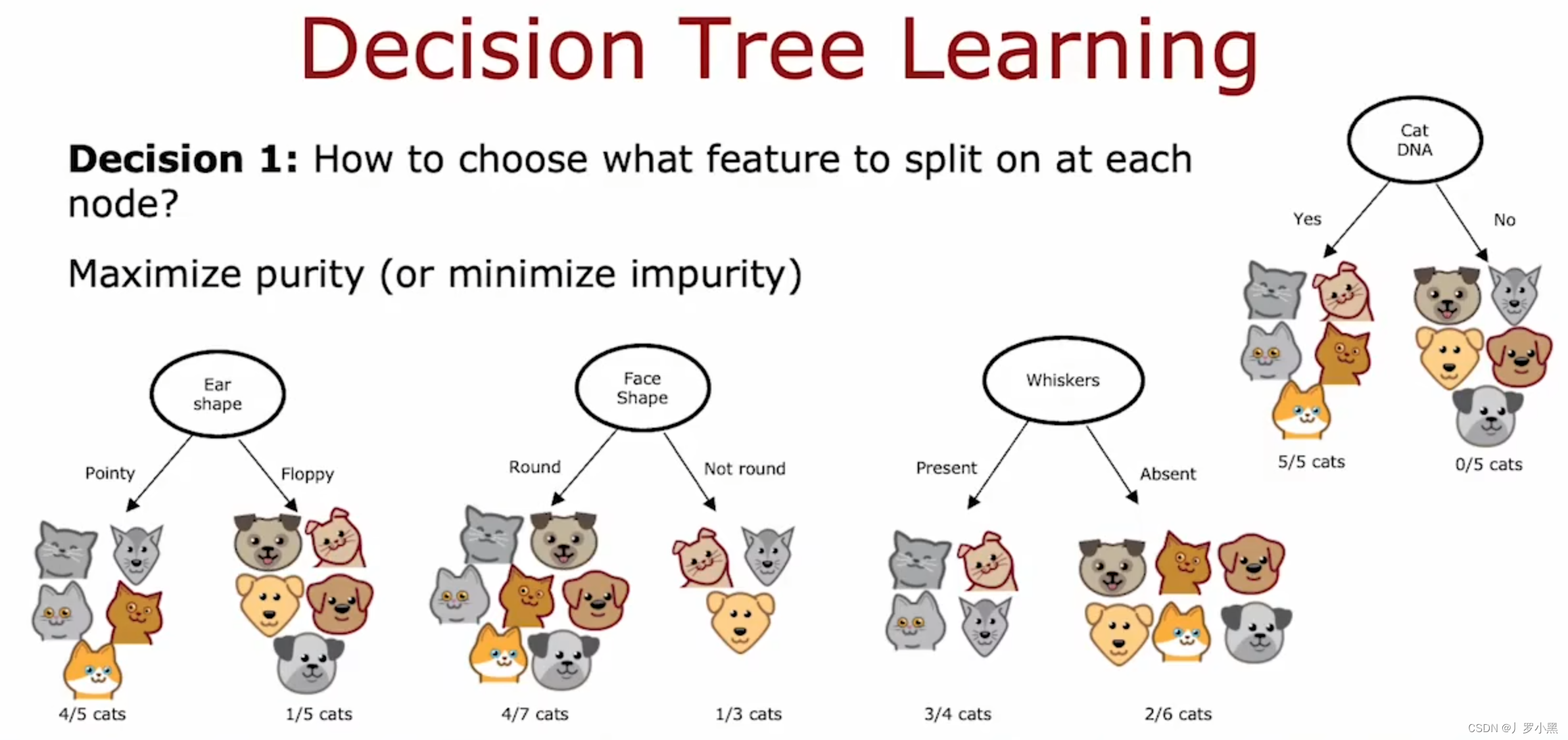

- 在构建决策树的过程中,有几个关键决定

- 决定一:如何选择特征作为每一个节点?决策树算法通过最大化纯度来选择特征作为节点,从而对数据集进行拆分

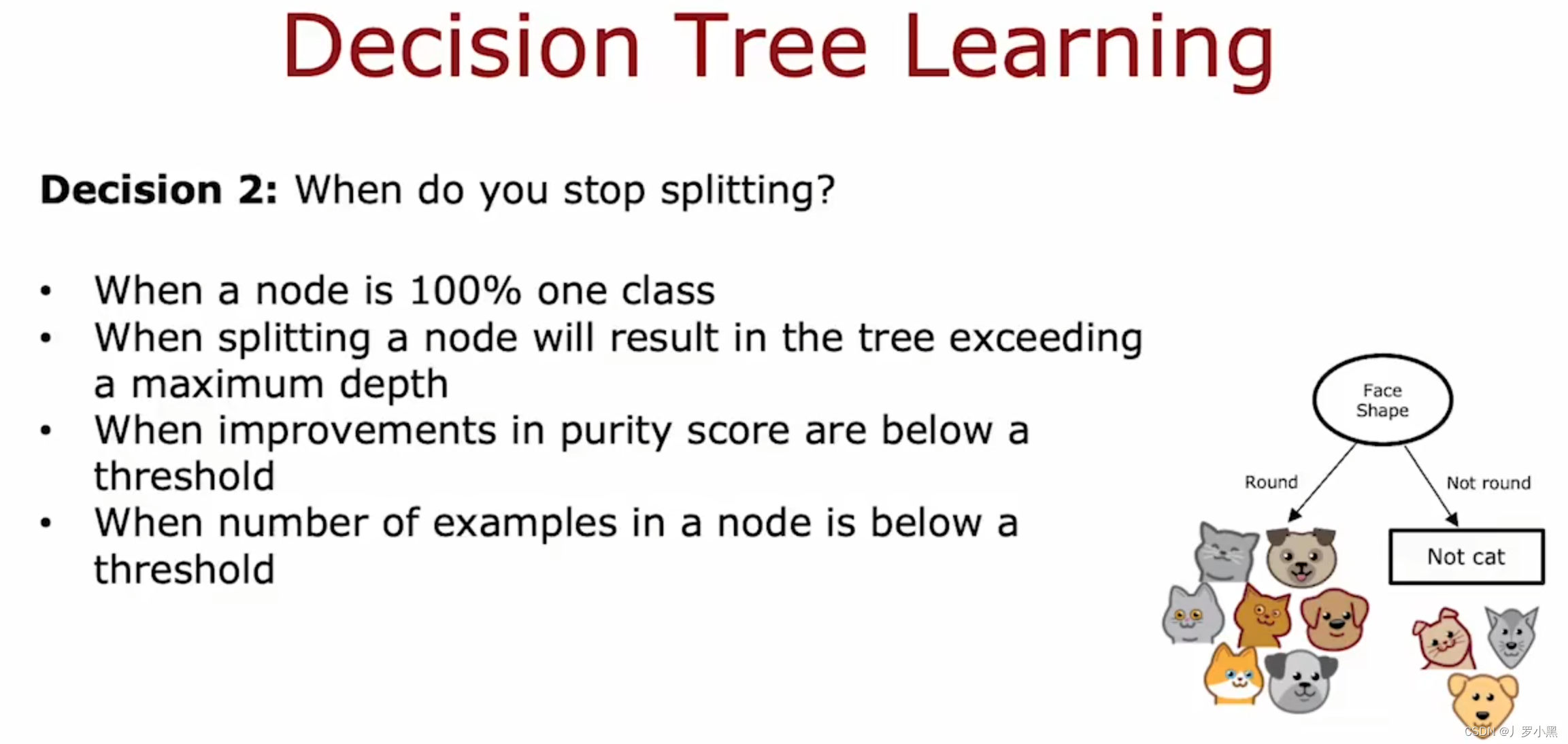

- 决定二:什么时候停止拆分?当某个节点处的数据的纯度为100%时,当拆分某个节点后会导致决策树超过最大深度时,当拆分节点后对纯度影响太小时,当某个节点的示例数量太少时

- 根节点的深度为0,停止拆分的原因是为了确保我们的树不会变得太大和太笨重,保持树很小,就不太容易过拟合

文章来源地址https://uudwc.com/A/nPyeV

文章来源:https://uudwc.com/A/nPyeV