神经网络-线性层

- 官方文档

- 自行了解的网络层

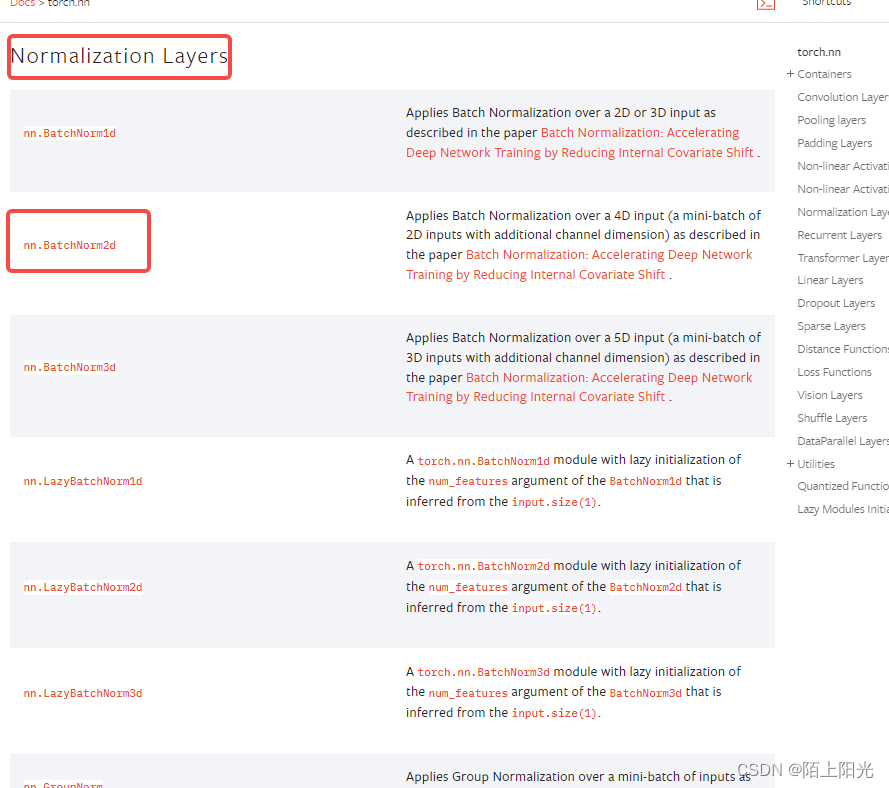

- 归一化层 Normalization

- 循环层 Recurrent

- Transformer

- Alphafold

- Dropout

- Sparse 稀疏层

- Distence 距离函数

- Loss 损失函数

- 线性层

官方文档

https://pytorch.org/docs/stable/nn.html#normalization-layers

自行了解的网络层

归一化层 Normalization

百度 弹幕 都说Normalization是归一化层【标准化层】,regulation才是正则化层

https://blog.csdn.net/weixin_40895135/article/details/130651226

循环层 Recurrent

多用于文字识别

Transformer

Alphafold

https://zhuanlan.zhihu.com/p/393699764?utm_medium=social&utm_oi=1144761973647597568

Dropout

目的: 防止过拟合

Sparse 稀疏层

https://blog.csdn.net/qq_51870267/article/details/126413057

只计算非零特征,对输入图像降维

Distence 距离函数

计算两个值的距离 衡量两个值之间的误差

Loss 损失函数

根据损失函数 可以判断模型的好坏,也可以以此去调整模型

损失函数越小,模型越好 L(f(x), Y)

线性层

文章来源:https://uudwc.com/A/zkrvO

文章来源:https://uudwc.com/A/zkrvO

文章来源地址https://uudwc.com/A/zkrvO

文章来源地址https://uudwc.com/A/zkrvO